Die Woche vom 12. bis 19. Oktober 2025 markiert einen Wendepunkt in Anthropics Strategie. Drei Ankündigungen innerhalb weniger Tage: Claude Haiku 4.5 am 15. Oktober, das Skills-System am 16. Oktober, und die Microsoft 365-Integration via Model Context Protocol. Zusammen adressieren sie ein zentrales Problem der Enterprise-AI: Die Lücke zwischen technischer Leistungsfähigkeit und wirtschaftlicher Sinnhaftigkeit.

Dan Shipper, Gründer des Medienunternehmens Every, beschreibt das Dilemma in einem Artikel: Sein Team hatte Claude Sonnet 4.5 für ihren KI-gestützten E-Mail-Assistenten Cora genutzt. „Then we got our Anthropic bill that month, and COO Brandon Gell told us that Every would go out of business if we didn’t figure out how to make it work with GPT-5-mini.“ Sie wechselten zu OpenAIs günstigerem Modell. Mit Haiku 4.5 kehrten sie zurück: „It works incredibly well inside of Cora, and it’s not priced like beluga caviar.“

Die Frage ist, ob diese Neuausrichtung die Balance zwischen Qualität und Kosten tatsächlich verschiebt – oder nur geschickter vermarktet.

Haiku 4.5: Fast wie Sonnet, aber dreimal günstiger

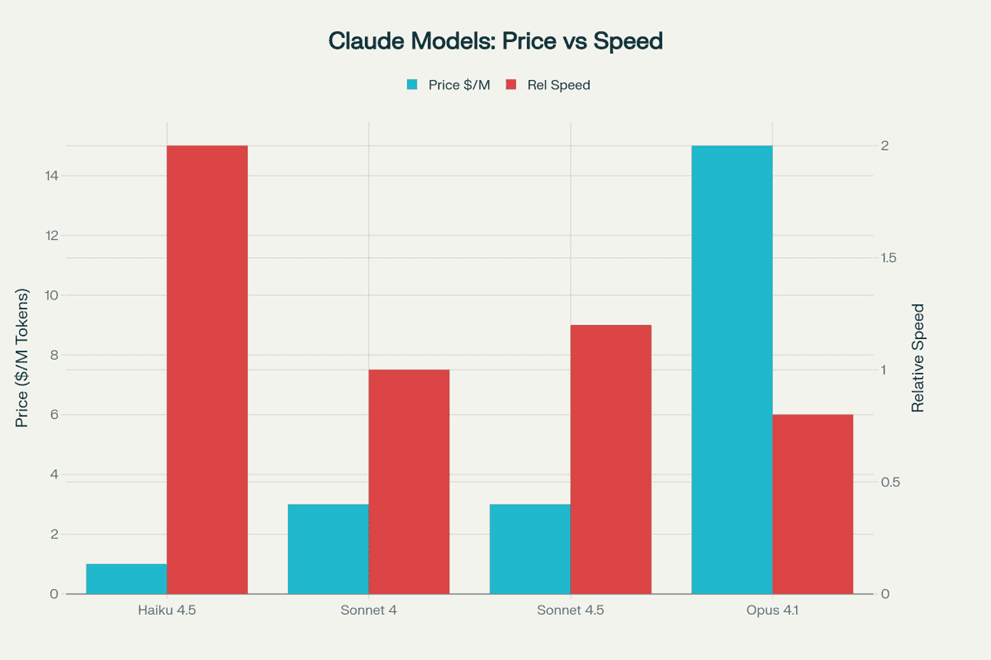

Am 15. Oktober stellte Anthropic Claude Haiku 4.5 vor – ein Modell, das vor fünf Monaten noch als Frontier gegolten hätte, jetzt aber als „effiziente Option“ vermarktet wird. Die zentrale Behauptung: Es liefert ähnliche Coding-Performance wie Claude Sonnet 4 (nicht Sonnet 4.5!), aber zu einem Drittel der Kosten und mehr als doppelter Geschwindigkeit.

Die Preisstruktur liegt bei $1 pro Million Input-Tokens und $5 für Output – verglichen mit Sonnet 4.5’s $3/$15. Das klingt nach einem Schnäppchen, bis man die Konkurrenz betrachtet: OpenAIs GPT-5 Mini kostet etwa $0.25/$2.50, Googles Gemini 2.5 Flash liegt ähnlich. Haiku 4.5 ist also immer noch viermal teurer als die Budget-Optionen der Konkurrenz.

Was die Benchmarks zeigen

Anthropic liefert beeindruckende Zahlen: 73,3% auf SWE-bench Verified (dem Industrie-Standard für Software-Engineering-Fähigkeiten), was praktisch identisch mit Sonnet 4’s 73,7% ist. Bei Computer-Use-Aufgaben – also der Fähigkeit, tatsächlich mit GUIs und Desktops zu interagieren – übertrifft Haiku mit 50,1% sogar deutlich Sonnet 4’s 42,2%.

Simon Willison, ein renommierter Entwickler und AI-Analyst, der eine umfassende Preisdatenbank für KI-Modelle pflegt, testet Haiku 4.5 sofort nach Release. Sein Fazit ist nüchtern: „Ich hatte gehofft, dass Anthropic endlich ein schnelles, günstiges Modell herausbringt, das preislich mit den billigsten Modellen von OpenAI und Gemini mithalten kann. Haiku 4.5 ist das sicherlich nicht.“ Gleichzeitig lobt er die neue Fähigkeit zum „extended thinking“ – Haiku kann nun, wie die größeren Modelle, bewusst mehr Rechenzeit für komplexe Probleme aufwenden.

Was sich konkret ändert: Haiku 4.5 unterstützt erstmals 200.000 Token Kontext (statt 48.000 bei Haiku 3.5) und 64.000 Token Output (statt 8.192). Der Knowledge Cutoff liegt bei Februar 2025 – einen Monat später als bei den Sonnet- und Opus-Modellen. Und eine technische Finesse, die Anthropic im System Card erwähnt: Das Modell wurde trainiert, sich seiner Kontext-Auslastung bewusst zu sein. Es lernt, Antworten abzurunden, wenn das Limit naht, und ausdauernder zu arbeiten, wenn noch Platz vorhanden ist.

Community-Reaktionen: Zwischen Begeisterung und Skepsis

Die Entwickler-Community ist gespalten. Auf Reddit beschreibt ein Nutzer von CTOL.digital das Kernproblem: „Das Coding ist in Ordnung, aber es ist wirklich schwer, mit ihm zu konversieren und Geschäftsanforderungen oder normale tägliche Unterhaltungen zu verstehen.“ Haiku 4.5 scheint für strukturierte Coding-Aufgaben optimiert, kämpft aber bei natürlicher Kommunikation.

Ein YouTuber, der ausführliche Tests durchführt, kommt zu einem vernichtenden Urteil: „Es ist grundsätzlich schlechter als Claude Sonnet 4 in fast jeder Hinsicht. Und es könnte das schlechteste Modell sein, das ich getestet habe.“

Doch die Praxis erzählt eine andere Geschichte. GitHub integriert Haiku 4.5 innerhalb von Tagen in Copilot, mit dem Kommentar: „Vergleichbare Qualität zu Sonnet 4, aber schneller.“ Das Team von Augment berichtet, dass Haiku „90% der Performance von Sonnet 4.5 erreicht“ und dabei „völlig neue Einsatzszenarien“ ermöglicht. Der CEO von Zencoder beschreibt es als Model, das „eine vollkommen neue Kategorie dessen eröffnet, was mit AI in Produktionsumgebungen möglich ist.“

Ayaan Haider, ein Flutter-Entwickler, der monatelang mit allen drei Claude-Modellen gearbeitet hat, findet einen pragmatischen Workflow: „Haiku für Setup-Aufgaben, Sonnet für komplexe Builds, Opus für finale Reviews.“ Seine Erkenntnis: „Haiku ist blitzschnell. Für UI-Arbeit unschlagbar. Aber erwarte nicht, dass es den ganzen Kontext über lange Sessions behält.“

Das Muster kristallisiert sich heraus: Haiku 4.5 ist kein Alleskönner, sondern ein spezialisiertes Werkzeug für spezifische Aufgaben – vor allem, wenn Geschwindigkeit und Kosteneffizienz wichtiger sind als absolute Genauigkeit.

Skills: Modulare Expertise ohne Prompt-Engineering

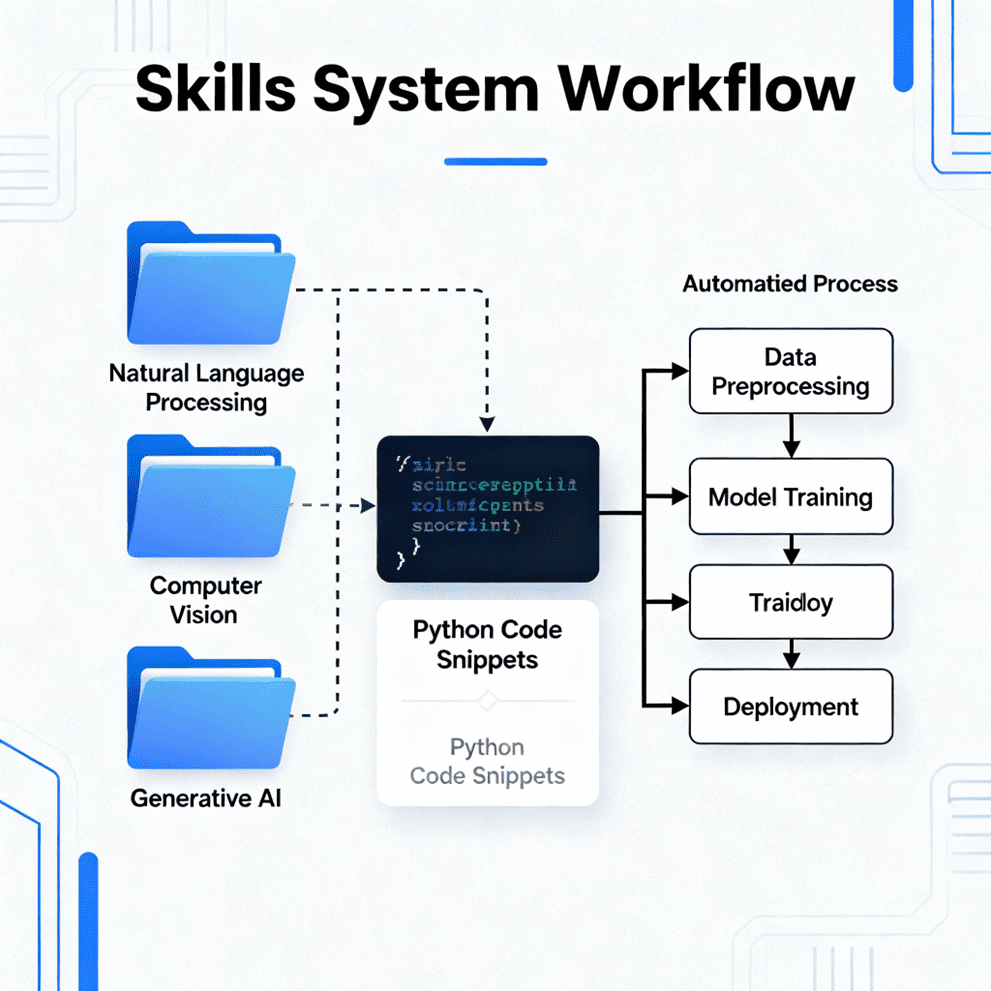

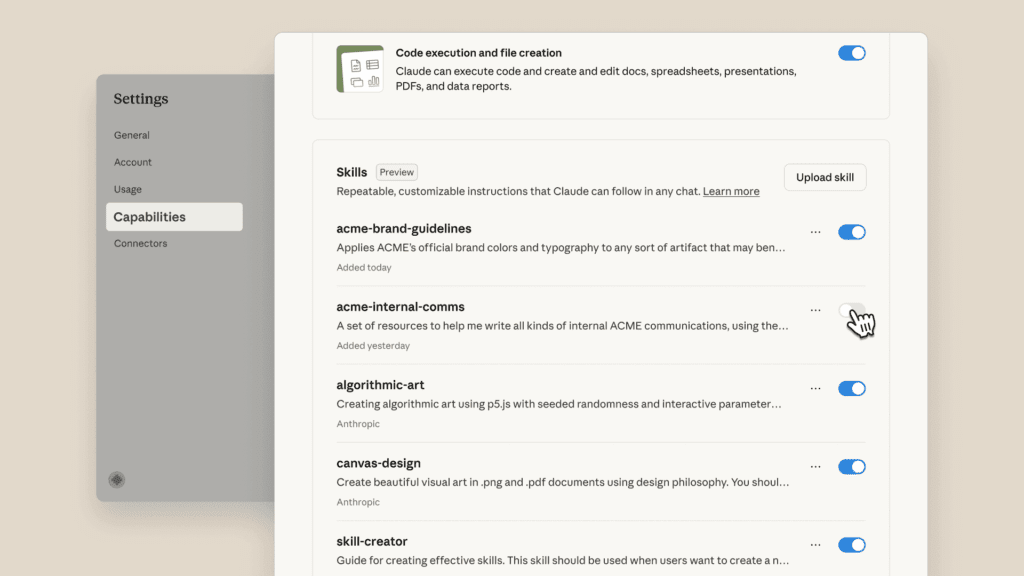

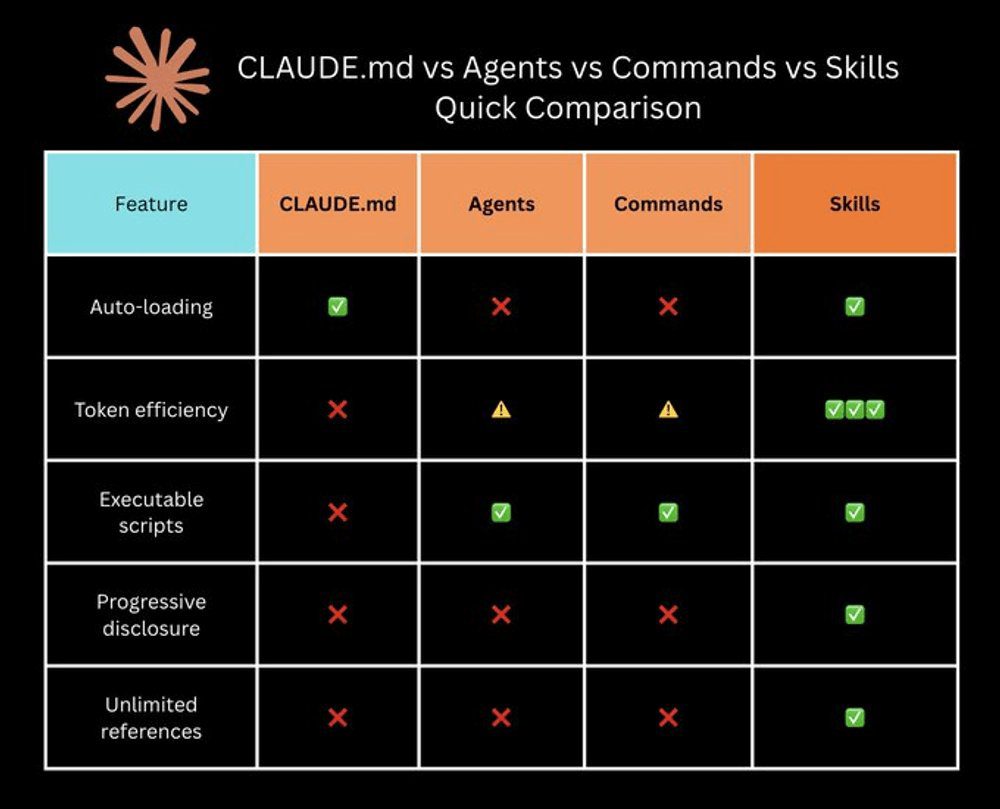

Einen Tag nach dem Haiku-Launch, am 16. Oktober, kündigte Anthropic das Skills-System an – möglicherweise die bedeutendere Innovation der Woche. Skills sind modulare Ordner mit Anweisungen, Skripten und Ressourcen, die Claude bei Bedarf „just in time“ laden kann.

Das revolutionäre Konzept: Progressive Disclosure. Claude erkennt automatisch, welche Skills für eine Aufgabe relevant sind, und lädt nur die minimal notwendigen Informationen. Simon Willison, der das System vor der offiziellen Ankündigung reverse-engineerte, analysiert: „Jeder Skill verbraucht nur wenige Dutzend Tokens bis zur Aktivierung. Das ist extrem token-effizient und möglicherweise bedeutender als MCP [Model Context Protocol].“

Wie Skills in der Praxis funktionieren

Die Community hat bereits beeindruckende Beispiele entwickelt. Besonders clever: Ein „Skill-Creator“ – ein Skill, der andere Skills erstellt. Nutzer beschreiben einfach ihre Anforderungen in natürlicher Sprache, und das System generiert automatisch die notwendige SKILL.md-Datei.

Weitere praktische Anwendungen, die in der ersten Woche entstanden:

Newsletter-Formatter: Verwandelt chaotische Stichpunkte in professionelle Newsletter-Texte. Ein Nutzer auf Tom’s Guide berichtet: „Hat vielleicht 10-15 Minuten zum Einrichten gedauert. Hat mir bereits Stunden an Wiederholungen erspart.“

Brand-Styler für Präsentationen: Wendet automatisch Corporate Identity auf PowerPoint-Folien an – Farben, Fonts, Logo-Platzierung, Tonalität.

Press Release Generator: Erstellt PR-Texte im AP-Stil basierend auf Produktdetails und Unternehmensinformationen.

Excel-Formula-Builder: Ein Enterprise-Nutzer berichtet von 65% Genauigkeit bei der Folienerstellung mit Haiku + Skills, verglichen mit 44% beim Premium-Tier-Modell ohne Skills – „ein Game-Changer für unsere Unit Economics.“

Ein Reddit-User fasst die Begeisterung zusammen: „Ich verwende Claude seit Monaten, und Skills fühlen sich wirklich transformativ an. Es geht nicht nur um bessere Prompts; es ist, als würde man Claude mit dauerhafter Expertise ausstatten.“

Der Unterschied zu Custom GPTs und Copilot Studio

OpenAI bietet Custom GPTs, Microsoft hat Copilot Studio – warum also die Aufregung um Skills? Der entscheidende Unterschied liegt in der Architektur.

Custom GPTs sind im Wesentlichen vor-konfigurierte Instanzen mit festen Kontexten. Alles, was du in ein Custom GPT packst, belastet den Kontext permanent – egal, ob es gerade relevant ist oder nicht.

Skills hingegen nutzen das Progressive Disclosure-Prinzip: Claude lädt einen Skill erst, wenn er gebraucht wird, und entlädt ihn wieder, wenn die Aufgabe erledigt ist. Das ermöglicht eine Art „Skill-Komposition“ – mehrere Skills können für komplexe Workflows kombiniert werden, ohne dass der Kontext überlastet wird.

Ein Anthropic-Engineer erklärt den Unterschied: „Im Gegensatz zu RAG [Retrieval-Augmented Generation] nutzt dies einfache Tools, die es Claude ermöglichen, aus einem Dateisystem zu lesen. Skills können unbegrenzte Mengen an Kontext enthalten, um Claude anzuweisen, wie Aufgaben zu erledigen sind.“

Die strategische Brillanz: Skills sind portabel und open-source. Einmal erstellt, können sie über Teams oder Organisationen hinweg geteilt werden. Anthropic liefert die Plattform, die Community liefert die Expertise. Das ist elegant – und lagert die schwerste Arbeit (Domain-spezifische Anpassung) an die Nutzer aus.

Microsoft 365-Integration: Der strategische Schachzug

Die dritte Ankündigung der Woche – die Microsoft 365-Integration via Model Context Protocol (MCP) – ist auf den ersten Blick die unspektakulärste. Jeder Enterprise-AI-Anbieter bietet ähnliche Integrationen. Doch das Timing und der Partner machen sie bemerkenswert.

Claude kann nun direkt auf SharePoint, OneDrive, Outlook, Teams und Kalender zugreifen. Eine typische Anfrage: „Was ist die Richtlinie unseres Unternehmens zur Fernarbeit?“ Claude durchsucht HR-Dokumente in SharePoint, E-Mail-Diskussionen in Outlook und Team-Richtlinien aus verschiedenen Quellen und erstellt einen umfassenden Bericht.

Das Sicherheitsmodell

Anthropic betont die Sicherheitsaspekte: „Alle Berechtigungen sind delegierte Berechtigungen. Wenn Sie keinen Zugriff auf etwas in Microsoft 365 haben, hat Claude auch keinen.“ Das System spiegelt bestehende Microsoft 365-Berechtigungen wider und kann nur auf Daten zugreifen, wenn explizit danach gefragt wird.

Die Enterprise-Search-Funktion ist bereits für alle Team- und Enterprise-Kunden verfügbar, wobei Administratoren zunächst die zu integrierenden digitalen Ressourcen auswählen müssen.

Warum das wichtig ist

Microsoft bietet bereits Copilot – das primär auf OpenAIs Modellen läuft. Doch Microsoft hat kürzlich Claude Sonnet 4 und Opus 4.1 als wählbare Modelle in Microsoft 365 Copilot hinzugefügt. Unternehmen können nun zwischen verschiedenen AI-Providern wählen.

Anthropics Connector positioniert Claude nicht als Ersatz für Microsofts Ökosystem, sondern als Ergänzung. Das ist strategisches Jiu-Jitsu: Statt Microsoft frontal anzugreifen, bettet sich Anthropic in die bestehende Infrastruktur ein und bietet eine Alternative, die IT-Abteilungen aktivieren können, ohne bestehende Investments zu gefährden.

Chris McKay, Gründer der AI-Analyse-Site Maginative, analysiert: „Microsoft experimentiert zunehmend mit einem Multi-Modell-Ansatz und positioniert seine Plattform als Router, der das beste Modell für die jeweilige Aufgabe auswählt. Die Integration von Claude-Modellen in Microsoft 365 Copilot gibt Unternehmenskunden mehr Wahlmöglichkeiten.“

Die Compliance-Frage

Für Unternehmen in regulierten Branchen – besonders in Europa mit GDPR, oder in Sektoren wie Healthcare und Finance – entstehen allerdings Fragen. Cross-Cloud-Datenflüsse von Microsofts Infrastruktur zu Anthropics Verarbeitung haben Implikationen für Datenresidenz-Anforderungen, vertragliche Schutzmaßnahmen und regulatorische Compliance.

Ein Analyst warnt: „Cross-Cloud-Datenflüsse haben Auswirkungen auf Datenresidenz, vertragliche Schutzmaßnahmen und regulatorische Compliance.“ Für viele Unternehmen wird die Evaluationsphase Monate dauern – nicht wegen technischer Limitationen, sondern wegen juristischer Prüfungen.

Die Multi-Agent-Architektur: Wie alles zusammenhängt

Die wahre Innovation liegt nicht in den einzelnen Announcements, sondern in deren Zusammenspiel. Mike Krieger, Anthropics Chief Product Officer und Instagram-Mitgründer, beschreibt die Vision: „Wir geben den Leuten ein komplettes Agent-Toolbox, bei dem jedes Modell die richtige Kombination aus Intelligenz, Geschwindigkeit und Kosten für verschiedene Teile der Aufgabe hat.“

In der Praxis bedeutet das: Sonnet 4.5 plant und koordiniert, während mehrere Haiku 4.5-Instanzen Sub-Tasks parallel abarbeiten. Skills liefern die Domain-spezifische Expertise. Die Microsoft 365-Integration bringt den Unternehmens-Kontext. Das Ergebnis ist eine verteilte Intelligenz, die sich je nach Anforderung selbst organisiert.

Jeff Wang, CEO von Windsurf, beschreibt die Auswirkungen: „Haiku 4.5 handhabt komplexe Workflows zuverlässig, korrigiert sich in Echtzeit und behält Momentum ohne Latenz-Overhead. Für die meisten Entwicklungsaufgaben ist es die ideale Performance-Balance.“

Was die Zahlen verraten

Die finanziellen Dimensionen hinter diesen Ankündigungen sind beeindruckend. Anthropic meldet eine annualisierte Umsatzrate von $7 Milliarden im Oktober 2025, hochgerechnet von etwa $1 Milliarde zu Jahresbeginn. Das Unternehmen prognostiziert $9 Milliarden bis Jahresende und setzt sich interne Ziele von $20-26 Milliarden für 2026.

Nach der jüngsten Serie-F-Finanzierungsrunde, die $13 Milliarden einbrachte und von ICONIQ angeführt wurde, liegt die Bewertung bei $183 Milliarden post-money. Zum Vergleich: Im März 2025 lag die Bewertung noch bei $61,5 Milliarden – eine Verdreifachung innerhalb von sechs Monaten.

Anthropic bedient mittlerweile über 300.000 Business-Kunden, und die Anzahl der „Large Accounts“ – Kunden mit über $100.000 jährlichem Run-Rate-Revenue – ist im vergangenen Jahr um den Faktor sieben gewachsen.

Doch es gibt kritische Stimmen. Ed Zitron, ein Tech-Analyst, der sich auf AI-Ökonomie spezialisiert, warnt: „Diese Unternehmen berichten oder leaken bewusst ihre ‚annualisierten wiederkehrenden Einnahmen‘ – der Umsatz eines Monats, multipliziert mit zwölf. Das lässt sie viel erfolgreicher erscheinen, als sie tatsächlich sind, und gibt ihnen Credit für Einnahmen, die sie noch nicht gebucht haben.“

Die Realität: Beide großen AI-Unternehmen – Anthropic und OpenAI – verbrennen Milliarden mehr als sie einnehmen. OpenAI verlor 2024 etwa $5 Milliarden. Anthropics genaue Verluste sind nicht öffentlich, aber bei den massiven Infrastruktur-Investitionen, die für das Training und Betreiben dieser Modelle nötig sind, dürfte die Situation ähnlich sein.

Deloitte-Deployment: Der Enterprise-Realitätstest

Im Oktober kündigte Deloitte an, Claude auf 470.000 Mitarbeiter in 150 Ländern auszurollen – das größte Enterprise-Deployment, das Anthropic bisher vermeldet hat. Das ist kein Pilotprojekt, sondern ein Commitment.

Für Deloitte sind Skills der entscheidende Faktor: Statt Hunderttausende von Mitarbeitern in effektivem Prompting zu schulen, kann die Firma ihre Methoden, Templates und Compliance-Anforderungen in Skills packen, die Claude automatisch anwendet.

Diese Strategie – tief in bestehende Workflows einbetten, Reibung minimieren statt Transformation zu fordern – unterscheidet Anthropic von OpenAI. Während OpenAI auf Frontier-Capability setzt (GPT-5, Sora, Reasoning Models) und Consumer-Adoption (ChatGPT Plus, Voice Modes), spielt Anthropic das Enterprise-Wartespiel: zuverlässig, integriert, sicher.

Die Sicherheits-Prämie

Ein Detail, das in den meisten Berichten untergeht: Haiku 4.5 ist als AI Safety Level 2 (ASL-2) klassifiziert, während größere Modelle wie Sonnet 4.5 und Opus 4.1 die restriktivere ASL-3-Bezeichnung tragen.

In automatisierten Alignment-Tests zeigte Haiku 4.5 statistisch signifikante Verbesserungen gegenüber seinen Vorgängern – weniger fehlausgerichtetes Verhalten, bessere Einhaltung von Sicherheitsrichtlinien, reduzierte Risiken bei sensiblen Themen wie chemischen oder biologischen Informationen. Anthropic nennt es ihr „sicherstes Modell bis heute.“

Praktisch bedeutet das: Haiku 4.5 hat einen niedrigeren „Sycophancy Score“ – es ist weniger geneigt, Nutzern nach dem Mund zu reden. In einer Branche, die zunehmend besorgt über AI-Systeme ist, die Nutzer-Biases verstärken, ist das wertvoll. Für regulierte Branchen – Healthcare, Finance, Government – macht es das Modell attraktiver, nicht trotz, sondern wegen seiner strengeren Guardrails.

Doch Sicherheit kostet auch Performance und Flexibilität. Die architektonischen Entscheidungen, die Haiku sicherer machen, machen es auch rigider in Konversationen und weniger flüssig bei mehrdeutigen Anfragen.

Was die Woche vom 12.-19. Oktober bedeutet

Anthropics Oktober-Offensive ist weniger ein technologischer Durchbruch als eine strategische Neupositionierung. Die drei Ankündigungen – Haiku 4.5, Skills, Microsoft 365-Integration – zielen auf ein spezifisches Problem: Die Lücke zwischen „AI kann das technisch“ und „Unternehmen können es sich leisten, es zu deployen.“

Haiku 4.5 macht Einsatzszenarien wirtschaftlich, die mit Sonnet zu teuer waren. Skills lösen das Prompt-Engineering-Problem durch Modularisierung. Die Microsoft-Integration fügt sich in bestehende Workflows ein, statt sie zu ersetzen.

Für Entwickler wie Dan Shipper, mit dem dieser Artikel begann, ist die Rechnung einfach: Haiku 4.5 macht bestimmte Anwendungen viable, die vorher zu teuer waren. Für Enterprises ist es eine Frage, ob Anthropics Safety-First-, Integration-Forward-Ansatz die Kosten-Prämie gegenüber Wettbewerbern rechtfertigt.

Die kritischen Stimmen – über Preise, Konversations-Limitationen, Compliance-Fragen – bleiben bestehen. Ebenso die breiteren wirtschaftlichen Fragen über eine Industrie, die Milliarden verbrennt, während sie auf Profitabilität hofft.

Doch die Adoption-Signale sind real. Deloittes 470.000-Mitarbeiter-Deployment ist kein Pilot. Microsoft, das Claude zu Copilot hinzufügt, ist Validation. GitHub, das Haiku innerhalb von Tagen integriert, ist Urgency.

Ob die aber als Wendepunkt der Enterprise-AI-Adoption in Erinnerung bleibt oder nur als weiterer Hype-Cycle der AI-Bubble, wird sich 2026 zeigen. Vorerst hat Anthropic demonstriert, dass „schneller, günstiger, integrierter“ – selbst wenn nicht „besser“ – für viele Unternehmen genau die richtige Kombination sein könnte.

Wir wrden wie immer alle Neuerungen ausführlich und tiefer besprechen, wenn möglich und sinnvoll auf Aimagick zur Verfügung oder ins Saas integrieren.