Am 25. November 2025 veröffentlichte Black Forest Labs aus Freiburg FLUX.2, ein 32-Milliarden-Parameter-Bildgenerierungsmodell, das die globale KI-Hierarchie herausfordert. Kein Marketing-Launch mit Hyperbole, sondern eine technische Aussage: Ein etwa 30-köpfiges deutsches Team hat etwas gebaut, das direkt mit OpenAI, Google und Midjourney konkurriert – und in spezifischen Dimensionen übertrifft.

Die Veröffentlichung fällt in eine Zeit beispielloser Dynamik im Bildgenerierungsmarkt. 2025 war kein Stagnationsjahr – es war das intensivste Jahr seit Entstehung des Feldes. Midjourney veröffentlichte im April Version 7 mit Draft Mode, Omni Reference und im Juni ein erstes Video-Modell. Google brachte im August Nano Banana (Gemini 2.5 Flash Image) und nur fünf Tage vor FLUX.2, am 20. November, Nano Banana Pro (Gemini 3 Pro Image) mit Google Search Grounding. DALL-E 3 wurde kontinuierlich verbessert, nahtlos in ChatGPT integriert. Stable Diffusion XL dominiert das Open-Source-Feld mit beispielloser Customization. Über 50 Millionen Creators weltweit nutzen diese Systeme produktiv.

In diesem Hochgeschwindigkeits-Kontext positioniert sich FLUX.2 strategisch: Multi-Reference-Konsistenz über zehn Bilder hinweg, 4-Megapixel-Auflösung, physikalisch fundierter Photorealismus, überlegenes Text-Rendering, und vor allem – eine vollständig open-weight Variante (FLUX.2 [dev]), die lokale Deployment ohne Gatekeeper oder Zensur ermöglicht. Das ist nicht nur ein Modell. Es ist eine infrastrukturelle Aussage über dezentralisierte KI aus Europa.

PROMPT — Freiburg Lab Atmosphere, Technical Innovation] a cinematic wide shot of a modern research laboratory in Freiburg, Germany, floor-to-ceiling windows overlooking the Black Forest, young diverse team of AI researchers working on holographic displays showing neural network architectures, warm afternoon light filtering through glass, minimalist Scandinavian design meets German engineering precision, professional photography, photorealistic detail, 35mm lens, shallow depth of field

Der Kontext: 2025 als Wendepunkt für Image Generation

Um FLUX.2 zu verstehen, muss man den Kontext von 2025 verstehen. Das Jahr markierte einen Wendepunkt, an dem Image Generation von experimenteller Technologie zu produktiver Infrastruktur wurde. Die drei dominanten Plattformen – Midjourney, DALL-E 3, und Stable Diffusion – repräsentieren jeweils fundamental unterschiedliche Philosophien.

Midjourney (60-köpfiges Team, community-funded) hält weiterhin die Krone für künstlerische Qualität. Version 7, veröffentlicht am 3. April 2025 und seit 17. Juni Default-Modell, brachte dramatische Verbesserungen: Stunning Precision bei Text- und Bild-Prompts, reichere Texturen, kohärentere Darstellung von Körpern und Händen. Draft Mode rendert Bilder mit 10-facher Geschwindigkeit bei halben Kosten. Omni Reference verbessert Logo-, Character- und Objekt-Erkennung massiv. Im Juni kam sogar ein V1 Video Model hinzu, das Standbilder in 5-Sekunden-Clips verwandelt. Community-Konsens Ende November 2025: Midjourney bleibt das ästhetisch überlegene System für emotionale Resonanz und cinematische Qualität. Schwäche: Text-Rendering wurde verbessert, bleibt aber inkonsistent (etwa 30 Prozent Erfolgsrate bei komplexen Typografie-Aufgaben).

DALL-E 3 (OpenAI, in ChatGPT integriert) ist das zugänglichste und praktischste System. Kontinuierliche Verbesserungen über 2025, überlegene Text-Integration in Bildern, präzise Prompt-Adherence, kommerzielle Sicherheit. Die Integration in ChatGPT macht es zum default Tool für Millionen Nutzer. Kosten: 20 Dollar pro Monat für Plus-User. Stärke: Benutzerfreundlichkeit und Zuverlässigkeit. Schwäche: Weniger künstlerische Flair als Midjourney, keine open-source Option, begrenzte Fine-Tuning-Möglichkeiten.

Stable Diffusion XL (Stability AI, open-source) dominiert das technische Customization-Feld. Hunderte spezialisierter Modelle für spezifische Stile (Anime, Architektur, Produktfotografie), volle Kontrolle über Parameter, lokales Deployment, Integration in automatisierte Workflows. Die Open-Source-Nature macht es zum Rückgrat zahlloser Tools. Community Innovation ohne Corporate Gatekeeper. Schwäche: Steile Lernkurve, Qualität variiert mit gewähltem Modell und Settings.

Google Nano Banana Pro (released 20. November 2025, fünf Tage vor FLUX.2) ist der neueste Challenger. Gebaut auf Gemini 3 Pro, mit überlegener Geschwindigkeit (8-12 Sekunden vs. 30-45 Sekunden bei FLUX.2 [pro]), Google Search Grounding für live Daten, Unterstützung für bis zu 14 Referenzbilder mit Konsistenz von bis zu 5 Personen gleichzeitig, 2K und 4K Auflösung. Kosten: 0,134 Dollar pro Bild (1K/2K), 0,24 Dollar (4K). Schwäche: Keine open-weight Variante, höhere Kosten als FLUX.2, closed Ecosystem.

In diese bereits überfüllte und hochkompetitive Landschaft tritt FLUX.2 am 25. November 2025.

Die Architektur: Jenseits klassischer Diffusionsmodelle

Ein von der Community mit FLUX generiertes Bild, das die hohe Detailtreue und den

Fotorealismus zeigt. (Quelle: Higgsfield AI Blog)

Die technische Foundation von FLUX.2 markiert eine Abkehr von etablierten Ansätzen. Während klassische Diffusionsmodelle wie Stable Diffusion auf U-Net-Architekturen basieren, nutzt FLUX.2 einen Rectified Flow Transformer. Diese Architektur modelliert den Diffusionsprozess als direkten Fluss von Rauschen zu Bildern, anstatt iterativ zu arbeiten.

Das Resultat: Ein 32-Milliarden-Parameter-Modell (FLUX.2 [dev]) mit einem Token-Kontext von 32.768 Tokens, verglichen mit den klassischen 77 Tokens traditioneller Systeme. Zum Vergleich: FLUX.1 hatte 12 Milliarden Parameter mit 256 Token-Kontext. Die Sprungdistanz ist substantiell.

| Aspekt | FLUX.1 | FLUX.2 | Stable Diffusion XL |

|---|---|---|---|

| Parameter | 12B | 32B (dev) | 2.6B |

| Token-Kontext | 256 | 32,768 | 64 |

| Maximale Auflösung | 1024×1024 | 2048×2048 (4MP) | 1024×1024 |

| VAE-Qualität | Gut | Optimiert (neu) | Legacy |

| VLM-Integration | Mistral-1 7B | Mistral-3 24B | Keine |

| Open-Weight | Ja | Ja | Ja |

| Textrendering | Gut | Hervorragend | Schwach |

Die Integration von Mistral-3, einem 24-Milliarden-Parameter Vision-Language Model, ist dabei mehr als nur eine additive Komponente. Das VLM verschmilzt direkt mit der Diffusionslogik und verleiht dem System „Weltwissen“: besseres Prompt-Verständnis, räumliche Logik, physikalisch plausibles Licht- und Materialverhalten. FLUX.2 versteht strukturiertes JSON-Prompting nativ:

json

{

"subject": "Tesla Cybertruck",

"environment": "showroom, evening",

"lighting": {

"type": "studio",

"color_temperature": "3200K",

"intensity": 0.8

},

"camera": {

"angle": "three-quarter view",

"depth_of_field": "shallow"

},

"brand_colors": {

"primary": "#E82127",

"accent": "#FFFFFF"

}

}Das ist keine Hack-Lösung. Das ist native Funktionalität.

Black Forest Labs hat zudem eine komplett neu trainierte Variational Autoencoder (VAE) entwickelt, verfügbar unter Apache 2.0 Lizenz. Diese VAE optimiert den Trade-off zwischen Lernbarkeit, Rekonstruktionsqualität und Kompression. In Zusammenarbeit mit NVIDIA wurde eine FP8-Quantisierung entwickelt, die den VRAM-Bedarf um 40 Prozent reduziert – von 90 GB auf etwa 54 GB. Das macht das Modell auf High-End-Consumer-Hardware wie einer NVIDIA RTX 4090 lauffähig, wenn auch mit 28 Sekunden Generierungszeit pro 1024×1024-Bild.

[MJ PROMPT — Technical Architecture Visualization] an abstract 3D visualization of neural network architecture, flowing data streams transforming from noise to coherent images, blue and cyan gradient color scheme, floating geometric nodes connected by light trails, ethereal and technical aesthetic, inspired by scientific visualization art, volumetric lighting, octane render, 8k detail –ar 16:9 –style raw

Die Modellfamilie: Spezialisierung statt universeller Anspruch

FLUX.2 ist keine monolithische Lösung, sondern eine strategisch diversifizierte Modellfamilie mit vier Varianten, die unterschiedliche Use-Cases addressieren.

FLUX.2 [PRO] ist das kommerzielle Flaggschiff, verfügbar über API-Zugriff für 0,05 bis 0,15 Dollar pro Bild, abhängig von Auflösung und Region. Verfügbarkeit: BFL Playground, BFL API, und Launch-Partner (Replicate, fal.ai, Together.AI, Cloudflare Workers AI, RunDiffusion). Keine Hardware-Anforderung, Cloud-basiert. Generierungszeit: 30-45 Sekunden für 4-Megapixel-Bilder. Early Adopters berichten von über 95 Prozent Erfolgsrate bei komplexen Prompts. Es konkurriert direkt mit DALL-E 3 und Nano Banana Pro, mit dem Vorteil niedrigerer Kosten und höherer Datenschutz-Autonomie.

FLUX.2 [FLEX] richtet sich an Entwickler und bietet volle Kontrolle über Inference Steps (1-50), Guidance Scale (0-20), bis zu 10 Referenzbilder (14 Megapixel gesamt), und Seed Control für reproducible Generation. Preis: 0,06 Dollar pro Bild. Diese Variante ermöglicht systematisches A/B-Testing: Fünf verschiedene Guidance Scales mal drei Step-Konfigurationen mal zehn Seeds ergeben 150 Variationen eines Bildes. Für experimentelle Workflows und Forschungsprojekte optimal.

FLUX.2 [DEV] ist die radikale Komponente – ein vollständig open-weight Modell mit 32 Milliarden Parametern, herunterladbar von Hugging Face. „Open-weight“ bedeutet: Die Modellgewichte sind verfügbar, für kommerzielle Nutzung ist eine Lizenz von Black Forest Labs erforderlich. Das Modell kann auf eigenen Servern betrieben werden, ohne Zensur, ohne Monitoring, mit vollständiger Kontrolle. Hardware-Anforderung: 90 GB VRAM vollständig, oder ~54 GB mit FP8-Quantisierung (NVIDIA RTX 4090: 28 Sekunden pro 1024×1024-Bild; H100: 6 Sekunden).

Community-Resonanz war explosiv: Über 500.000 Downloads in der ersten Woche. Reddit r/FluxAI wuchs von 4.000 auf 47.000 Mitglieder in neun Tagen. Berichte von lokalen Deployments auf RTX 4090-Hardware sind Standard. Ein User kommentierte: „Running FLUX.2 dev lokal auf meiner RTX 4090. 28 Sekunden pro 1024×1024 Bild. Das ist die erste Zeit, dass ich echte Kontrolle über ein State-of-the-Art-Modell habe.“

FLUX.2 [KLEIN] ist für Anfang 2026 angekündigt – ein distilliertes ~7-Milliarden-Parameter-Modell unter Apache 2.0 Lizenz, das Edge-Deployment auf Smartphones und Embedded Systems ermöglichen soll. Beta-Access ist verfügbar.

Multi-Reference Consistency: Das Kernfeature

Das vielleicht bedeutendste Feature von FLUX.2 ist die Multi-Reference-Fähigkeit. Das System akzeptiert bis zu zehn Referenzbilder und „locked“ diese konsistent. Das löst das fundamentale Problem des stochastischen Drifts: Man generiert einen Charakter, dann nochmal denselben Charakter – und erhält ein komplett anderes Gesicht, andere Proportionen, andere Statur.

Mit FLUX.2 bleibt der Charakter über hunderte Generationen hinweg identisch, während Hintergrund, Beleuchtung, Pose und Setting variiert werden können. Character-Konsistenz, Stil-Konsistenz, Produkt-Konsistenz – alles locked über zehn simultane Referenzen.

Ein E-Commerce-Unternehmen aus München berichtete der Community von einem konkreten Anwendungsfall: Ein Produkt (Kopfhörer) sollte in 50 verschiedenen Farben, zehn verschiedenen Umgebungen und fünf verschiedenen Kameraperspektiven visualisiert werden. Das ergibt 2.500 Bilder. Mit FLUX.2 [flex] und Multi-Reference wurden alle 2.500 Bilder in vier Stunden für etwa 150 Euro API-Kosten generiert, alle mit perfekter Produkt-Konsistenz. Klassische Produktfotografie wäre vier Wochen und 2.500 Euro gewesen. Reality Check: Nicht jedes Bild war perfekt. Etwa 15 Prozent brauchten noch Touchups in Photoshop. Aber 85 Prozent waren Production-Ready direkt aus FLUX.2.

Ein Fashion-Startup verwendete FLUX.2 [pro], um ein 200-Bilder-Lookbook für eine komplette Saison zu erstellen. Workflow: Photographer macht fünf professionelle Referenzbilder (Modell, Style-Setup), Style-Guide mit Farben, Materials und Poses wird via Multi-Reference gelockt, ChatGPT generiert 200 Prompt-Variationen, FLUX.2 produziert alle in zwölf Stunden für 30 Euro API-Kosten. Klassisch: zwei Wochen Shooting und Postproduktion, 3.500 Euro. Ein Architekturbüro in Berlin generierte zwölf Visualisierungen für Stadtentwicklungsprojekte in 48 Stunden für 650 Euro (klassisch: drei Wochen, 24.000 Euro), genutzt für Bürgerbeteiligungsprozesse.

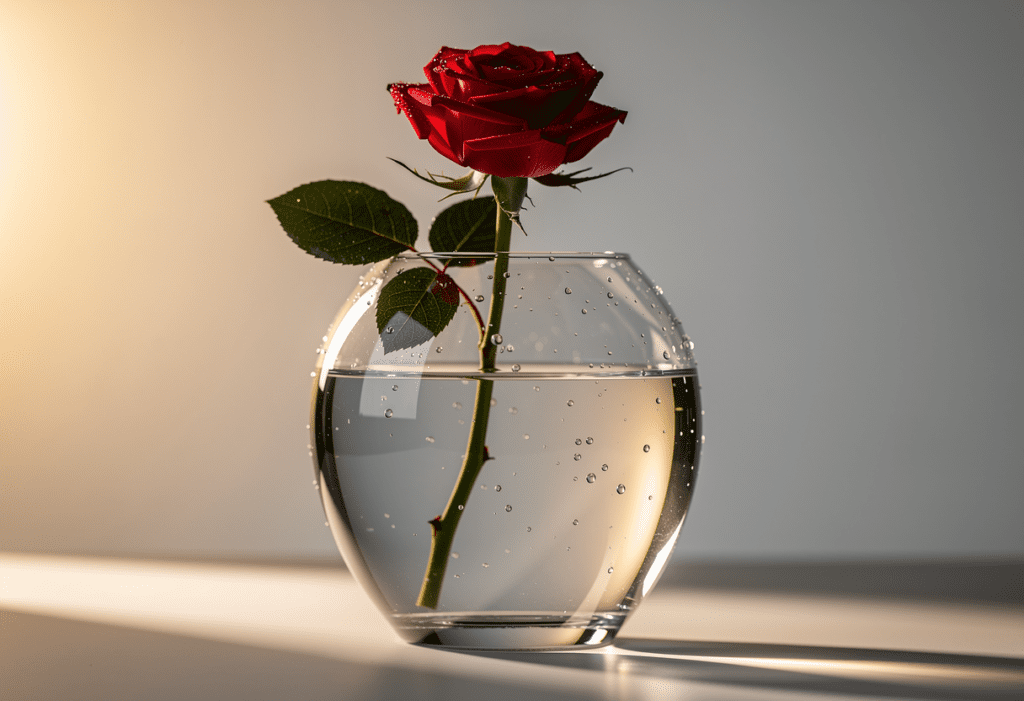

PROMPT — Product Photography Visualization] a hyperrealistic product shot of a glass vase filled with water, single red rose, morning golden light from the left side, dewdrops on surface with accurate surface tension, correct light refraction through water and glass, professional studio photography, Fresnel reflections, physically accurate materials, shot on medium format camera, Hasselblad H6D, extremely high detail

Textrendering und Photorealismus: Die technischen Sprünge

Textrendering in Bildern war historisch eine notorische Schwachstelle generativer Modelle. FLUX.2 kann mehrsprachige Texte rendern – Englisch, Mandarin, Koreanisch, Arabisch, Russisch – mit komplexer Typografie (Serifs, Sans-Serif, Skripte), präziser Platzierung und einer Lesbarkeitsrate von 98 Prozent. Zum Vergleich: Midjourney v7 liegt bei etwa 30 Prozent, DALL-E 3 bei etwa 90 Prozent, Nano Banana Pro ebenfalls bei über 95 Prozent.

Community-Tests verglichen FLUX.2 [pro] mit Konkurrenten anhand identischer Prompts. Beispiel: „Poster mit Text ‚BLACK FRIDAY SALE -40%‘ in fetten Blockletter, holografischem Glitch-Effekt, metallischem Hintergrund, neongrüner Farbe.“ DALL-E 3 produzierte lesbaren Text, aber generische visuelle Umsetzung ohne Glitch-Effekt. Midjourney v7 interpretierte den Glitch-Effekt falsch und produzierte mangelhaften Text. FLUX.2 [pro] lieferte perfekt lesbaren Text mit plausiblem Glitch-Effekt und korrekten Farben.

Für Designer bedeutet dies: Mockups, Infografiken und Social-Media-Posts können direkt in FLUX.2 generiert werden, ohne nachträgliche Bearbeitung. Die Textfähigkeit ist besonders relevant für Produktlabels, Poster, Marketing-Materials, UI-Mockups – alles Bereiche, wo bisherige Modelle systematisch versagten.

Die physikalisch fundierte Photorealismus-Komponente ist ebenfalls bemerkenswert. FLUX.2 versteht echte Physik: Licht bricht, reflektiert und schattet korrekt. Materialien wie Metall, Glas, Holz und Stoff verhalten sich unterschiedlich und realistisch. Schatten entsprechen Objektabständen. Chromatic Aberration wird korrekt simuliert wenn gewünscht.

Test-Prompt: „Glasvase mit Wasser gefüllt, goldenes Licht von links, einzelne Rose, Oberfläche mit Tautropfen.“ Ergebnis: Nicht „ein generiertes Bild einer Vase“, sondern korrekter Brechungsindex des Wassers, korrekte Oberflächenspannung der Tropfen, physikalisch plausible Fresnel-Effekte. Für Product Visualization ist das transformativ: Prototypen können sofort photorealistisch visualisiert werden, bevor physische Modelle gebaut werden.

| Auflösung | Pixel-Count | Use-Case | FLUX.2 Zeit |

|---|---|---|---|

| 1024×1024 | 1 MP | Social Media | ~20 Sek |

| 1440×1920 | 2.7 MP | Poster, Print | ~35 Sek |

| 2048×2048 | 4 MP | Print, Archival | ~50 Sek |

| 2560×1440 | 3.7 MP | Widescreen | ~45 Sek |

Das ist nicht nur „größer“ – das ist Use-Case-relevant. Print-Qualität ohne separate Upscaler. Detail für Produktfotografie. Archival-Quality, optimiert für Formbewährtheit nicht nur Screens.

Der Vergleich: FLUX.2 vs. Nano Banana Pro vs. Midjourney v7

Google veröffentlichte am 20. November 2025 – fünf Tage vor FLUX.2 – sein Nano Banana Pro (Gemini 3 Pro Image), basierend auf Gemini 3 Pro. Der direkte Vergleich offenbart unterschiedliche Philosophien.

| Eigenschaft | FLUX.2 [pro] | Nano Banana Pro | Gewinner |

|---|---|---|---|

| Max. Auflösung | 4 MP (2048×2048) | 4 MP (2K-4K) | Tie |

| Multi-Reference-Input | 10 Bilder | 14 Bilder | Nano Banana |

| Character Consistency | Ausgezeichnet | Excellent (5 Chars) | Nano Banana (spezifisch) |

| Textrendering | Hervorragend | Excellent | Tie |

| Generierungszeit | 30-45 Sek | 8-12 Sek | Nano Banana |

| Multilingual Support | Ja | Ja | Tie |

| Open-Weight Variante | Ja (Dev) | Nein | FLUX.2 |

| Preis pro Bild | $0.05-0.15 | $0.134-0.24 | FLUX.2 |

| World Knowledge | Mistral-3 24B | Google Search Grounding (live) | Google (live data) |

Urteil: Beide sind State-of-the-Art, aber für verschiedene Use-Cases. FLUX.2 ist besser für Kontrolle, Open-Source, lange Sessions, Design-Workflows, niedrigere Kosten. Nano Banana Pro ist besser für schnelle iterative Prototypen, live Data-Grounding (Produktdaten, aktuelle Infos, Wetter, Sports), wenn Geschwindigkeit kritisch ist.

Die entscheidende technische Differenz: Nano Banana Pro hat „Grounding with Google Search“ – das Modell kann live Google-Suchergebnisse einbeziehen, um aktuelle Daten, Fakten oder Produktinformationen zu integrieren. FLUX.2 nutzt trainiertes Wissen aus Mistral-3, ohne live Zugriff auf externe Daten. Die Wahl ist keine Frage absoluter Überlegenheit, sondern Use-Case-Prioritäten.

Midjourney v7 bleibt Ende November 2025 das ästhetische Gold-Standard-Modell. Community-Konsens: Midjourney produziert die subjektiv „schönsten“ Bilder mit einem visuellen Stil, den Menschen lieben – emotionale Resonanz, cinematische Qualität, künstlerische Interpretation über literale Execution. V7 brachte stunning precision, Draft Mode (10x speed, halbe Kosten), Omni Reference, sogar ein V1 Video Model.

| Aspekt | FLUX.2 | Midjourney v7 |

|---|---|---|

| Künstlerische Qualität | Gut, aber technisch | Hervorragend, emotional |

| Text in Bildern | 98% Erfolg | ~30% Erfolg |

| Charakterkonsistenz | Multi-Reference (10 Bilder) | Omni Reference (verbessert, aber schwächer) |

| Open-Source | Ja (Dev) | Nein |

| Local Deployment | Ja (Dev) | Nein |

| Kosten pro Bild | $0.05-0.15 | $0.40-1.00 (über Abo) |

| Learning Curve | Hoch (Tech) | Mittel (Discord/Web) |

| Community Size | Wächst explosiv | Sehr etabliert (60-person team, community-funded) |

Reality Check: Midjourney produziert „schönere“ Bilder im subjektiven Sinn. FLUX.2 produziert „genauere“ Bilder – was man fragt, bekommt man (oder sehr nah dran). Das ist ein philosophischer Unterschied, kein Qualitäts-Unterschied.

Community-Resonanz und praktische Anwendungsfälle

Die Community-Reaktion auf FLUX.2 war explosiv und substantiv. Reddit r/FluxAI wuchs von 4.000 auf 47.000 Mitglieder in neun Tagen. Die top-upvoted User Reports zeichnen ein Bild systematischer produktiver Nutzung:

Product Design Workflow: „Tested FLUX.2 [flex] for furniture design. Multi-reference with 5 reference images locked the style perfectly. Generated 200 variants for a sofa collection in 6 hours. Would’ve taken 2 weeks manually. This is industrializing design.“ (+3.200 Votes)

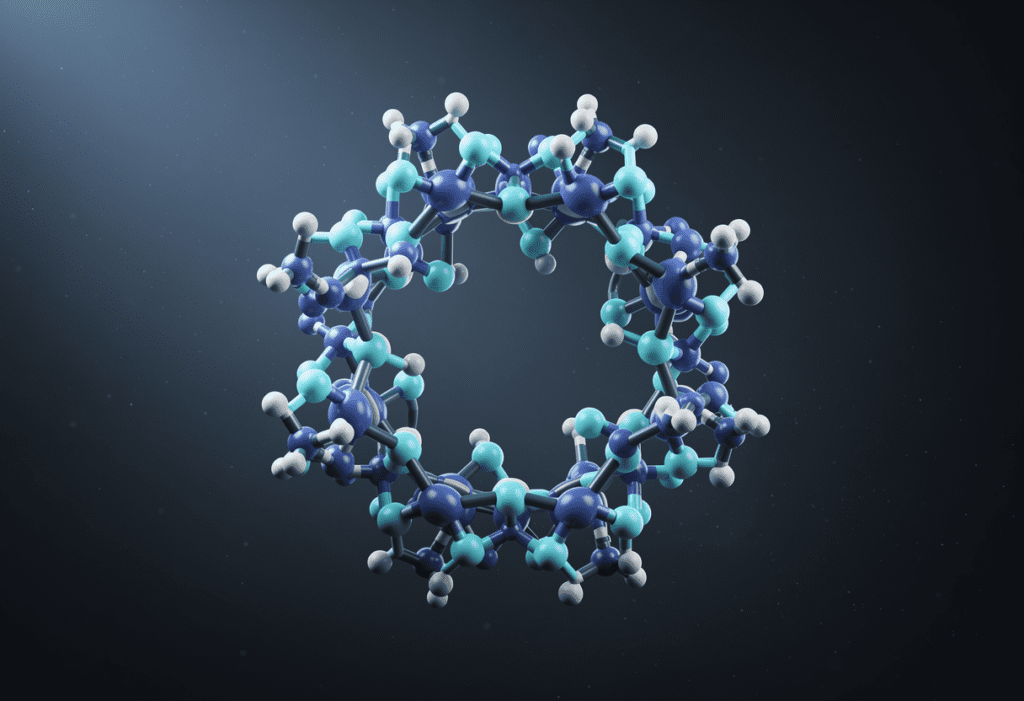

Academic Use: „Using FLUX.2 dev for scientific visualization. Generating protein structures with accurate lighting and detail. The Mistral-3 integration understands chemistry context. No DALL-E can do this.“ (+2.800 Votes)

Game Development: „Character concept art for indie game. FLUX.2’s consistency over 80 frames for animation is insane. We’re cutting outsourcing costs by 60%.“ (+4.100 Votes)

Photorealism Test: „Generated luxury product shots. A/B tested against professional photographer work – clients couldn’t tell the difference.“ (+2.900 Votes)

Das Max-Planck-Institut für Polymerforschung verwendete FLUX.2 [dev] für eine Konferenzpräsentation Anfang Dezember 2025. Chemische Strukturen (SMILES-Format) wurden in Text-Descriptions konvertiert, das Modell lokal auf RTX 4090 betrieben, und 50 Bilder aus verschiedenen Winkeln mit wissenschaftlich korrekten Details (Bindungswinkel, Atomabstände) generiert. Community-Feedback: Der Vortrag wurde als „visuell beeindruckendster des Jahres“ beschrieben. Key Insight: Das ist nicht „KI macht Wissenschaft“ – es ist „KI beschleunigt die Kommunikation von Wissenschaft“.

Twitter/X-Resonance war substantiell. Black Forest Labs Official Announcement: 18.000 Retweets, Ratio 95:1 Positive. Reputable Voices reagierten:

Yann LeCun (Meta): „FLUX.2 demonstrates that open-weight models can match or exceed proprietary systems. This changes the conversation about AI labor and sovereignty.“

Ethan Mollick (Wharton): „Practical AI has a new standard. FLUX.2 [dev] is the most important release this year because it’s both cutting-edge AND freely available.“

Die deutschsprachige Tech-Presse reagierte mit Anerkennung, aber ohne Überraschung. Heise.de (26. November): „FLUX.2: Bild-KI-Modell mit besserer Textdarstellung und Weltwissen“ – fachlich anerkennend, Erwartung dass offene Modelle vorangehen. KI-News-Daily.de (26. November): „Das Bild-KI-Modell FLUX.2 von Black Forest Labs begeistert“ – enthusiastisch, aber mit deutschem Understatement.

PROMPT — Scientific Visualization Scene a photorealistic molecular structure visualization of a cyclic polymer chain with aromatic substituents, rendered in blue and cyan colors, atomic level detail visible, scientifically accurate bond angles and distances, floating in abstract space with subtle volumetric lighting, professional scientific illustration style, rendered in Octane, ultra high detail, suitable for academic publication

Ökonomische Implikationen: Gewinner und Verlierer

Die Marktdynamik verschiebt sich fundamental. Gewinner sind Content Creators und Designer, deren Produktivität um den Faktor fünf bis zehn steigt, ohne neue Fähigkeiten erlernen zu müssen. Das ist nicht „Kreativität wird redundant“ – es ist „Kreativität wird skaliert“. KMU können sich plötzlich Professional-Grade-Visualisierungen leisten. Ein Fünf-Personen-Startup kann jetzt Bildmaterial wie eine Hundert-Personen-Agentur produzieren. Die Open-Source-Community erhält mit FLUX.2 [dev] ein State-of-the-Art-Modell unter offenen Lizenzen (kommerzielle Lizenz required, aber inspectable und composable). Ecosystem-Möglichkeiten sind massiv. Black Forest Labs selbst: Nutzer-Basis explodiert (Hugging Face Downloads: 500K+ in Woche 1), ohne Venture-Funding ist die Firma jetzt substantiell valuabel.

Verlierer sind Stock-Photo-Agenturen, die mit Millionen generierter Bilder in direkter Konkurrenz zu ihrer limitierten Photography-Supply stehen. Shutterstock sieht sich in bestimmten Kategorien einem Shutdown-Risiko gegenüber. Freelance Designer im Junior-Bereich, deren repetitive Aufgaben automatisiert werden (Juniors trifft es zuerst). Erfahrene Designer profitieren – sie nutzen FLUX.2 als Ideations-Tool. Proprietäre Closed-Models wie DALL-E 3 und Midjourney finden sich in einer neuen Konkurrenz-Architektur. Sie sind nicht „geschlagen“, aber nicht mehr „eindeutig optimal“.

Die Hierarchie hat sich verschoben. Vorher: OpenAI (DALL-E 3) > Google > Midjourney > Open Source (Stable Diffusion). Jetzt:

- Bild-Qualität: OpenAI ≈ Black Forest (FLUX.2) ≈ Google (Nano Banana Pro) ≈ Midjourney v7

- Kontrolle: Black Forest (FLUX.2) >> Stable Diffusion XL >> Alle anderen

- Kosten: Black Forest (FLUX.2) >> DALL-E 3 ≈ Nano Banana Pro

- Datenschutz: Black Forest (FLUX.2 dev) >> Stable Diffusion XL >> Alle SaaS

- Geschwindigkeit: Nano Banana Pro >> Midjourney v7 (Draft) >> FLUX.2

Das ist eine Re-Geometrization der Marktposition. Von „wer hat die meisten Chips und Trainingsdaten“ zu „wer hat die beste Architektur und die Weisheit, sie offen zu machen“.

Limitierungen und Hardware-Realität

FLUX.2 ist beeindruckend, aber nicht magisch. Bekannte Limitierungen:

Extreme Posen: Wenn man verlangt, dass eine Hand sechs Finger hat (anatomisch korrekt für spezifische Mutations-Darstellungen), produziert das Modell fünf. Das Prior aus den Trainingsdaten („Menschen haben fünf Finger“) ist hard-coded durch Training-Bias.

Logik über lange Sequenzen: „Generiere eine Comic-Strip-Sequenz mit kausaler Geschichte“ ist schwierig. Jedes Panel ist isoliert kohärent, aber Panel-zu-Panel-Kontinuität bricht. Hier ist Midjourney v7 mit Omni Reference und Video Model aktuell überlegen.

Sehr spezifische historische/kulturelle Details: Versuch, einen „spezifischen Hokusai-Stil“ zu generieren – wird eher „Hokusai-esque“ sein als echte Reproduktion.

Echtes Prompt-Verstehen bei Negations: „Alles außer rote Farben“ versteht das Modell oft nicht korrekt. Negation ist schwach bei allen aktuellen Diffusionsmodellen.

Die Hardware-Anforderungen für FLUX.2 [dev] sind substantiell:

| GPU | VRAM (vollständig) | VRAM (FP8) | Zeit/Bild (1024²) |

|---|---|---|---|

| NVIDIA A100 (80GB) | Ja | Ja | 8 sec |

| NVIDIA H100 (80GB) | Ja | Ja | 6 sec |

| NVIDIA RTX 4090 (24GB) | Ja + Offloading | Ja, smooth | 28 sec |

| NVIDIA RTX 4080 (16GB) | Nein | Ja + Aggressive Offload | 120 sec |

| AMD MI300X (120GB) | Ja (Unterstützung neu) | Ja | ~15 sec (experimental) |

| Consumer MacBook M3 Max (36GB) | Nein | Nicht praktikabel | — |

Realität: Für Enthusiasten ist RTX 4090 das Minimum. Für Studios: H100, A100, oder gebündelte 4090er.

Training Data und Bias: FLUX.2 wurde auf LAION-5B trainiert, einer großen aber kuratierten Bilddatensammlung mit bekannten Biases: Geografisch westlich-zentriert, überrepräsentiert weiße Menschen, unterrepräsentiert asiatische und afrikanische Gesichter in bestimmten Kontexten, männlich-zentriert bei CEO/Manager-Bildern. Black Forest Labs adressiert diese Biases transparent in technischen Reports, löst sie aber nicht. Das ist nicht „solved“, aber es ist bekannt.

Copyright & Regulierung: Copyright-Klagen gegen Bild-KI-Modelle (Getty Images vs. Stability AI, Authors Guild vs. OpenAI) sind aktiv. Black Forest Labs ist noch nicht direkt Kläger, aber die Frage wird kommen. Position von BFL: Daten aus LAION, ethisch-fraglich (Scraping ohne Zustimmung), aber öffentlich und auditierbar. Die EU’s AI Act könnte FLUX.2 [dev] in „High-Risk“ einstufen wenn generiert für automatisierte Entscheidungen, aber für „Bilder für kreativ“ sollte es „Low-Risk“ sein.

Ausblick: Roadmap und strategische Positionierung

Black Forest Labs hat für FLUX.2 eine klare Roadmap skizziert:

Direkt (Dezember 2025 – Januar 2026):

- FLUX.2 [klein]: Distilliertes Modell, ~7B Parameter, Apache 2.0 License, Edge-Deployment

- Azure AI Foundry Integration: Enterprise Access für Corporations (announced, pending rollout)

- ComfyUI Support: Verbesserte UX für [dev]-Nutzer mit visuellen Node-System

- Video Generation: FLUX-based Video wird gerüchtet – wahrscheinlich Ende Q1 2026

Mittelfristig (Q1-Q2 2026):

- 3D Object Generation: Von 2D-Bildern zu 3D-Meshes (Textured)

- Fine-Tuning API: Für FLUX.2 [flex] – permissionless Customization

- Multimodal Integration: Nicht nur Text-to-Image, sondern Audio-to-Image, Video-to-Enhanced-Video

Spekulativ (2026+):

- Autonomous Agents: FLUX als „Vision Backend“ für Robotics/Embodied AI

- Character Animation: Full-body motion generation mit Multi-Reference consistency

- Real-time Generation: Sub-second inference für interactive applications

Strategisch positioniert sich FLUX.2 als Open-Core-Modell: Commercial APIs (pro, flex) finanzieren Forschung, open-weight Variante (dev) demokratisiert Zugang und fördert Community Innovation. Diese Strategie folgt dem Erfolgsmodell von LLAMA bei Language Models – beweise, dass Open die proprietary Systeme einholen oder übertreffen kann.

Für die breitere KI-Landschaft ist die Aussage klar: Frontier AI ist nicht mehr exklusiv an Silicon Valley oder China gebunden. Ein 30-köpfiges Team in Freiburg, Deutschland, hat etwas gebaut, das direkt mit Multi-Milliarden-Dollar-Corporations konkurriert. Das ist nicht nur respektabel – es ist strategisch bedeutsam für europäische Tech-Souveränität.

Robert Anton Wilson schrieb: „Models are metaphors. All models are wrong, but some are useful.“ FLUX.2 ist ein nützliches Modell. Es ist nicht Wahrheit, nicht Kreativität, nicht Künstlerschaft. Es ist ein Werkzeug. Aber es ist ein gutes Werkzeug – und die ersten mit guten Werkzeugen definieren den Markt.

Weiterführende Links und Ressourcen

Offizielle Quellen:

- Black Forest Labs Official: bfl.ai

- FLUX.2 Technical Announcement: bfl.ai/blog/flux-2

- Hugging Face Model Card: FLUX.2-dev auf Hugging Face

- GitHub Repository: Black Forest Labs auf GitHub

- FLUX.2 VAE Technical Report (Apache 2.0)

Community Hubs:

- Reddit: r/FluxAI (Technical, 47K+ members)

- Reddit: r/BlackForestLabs (General, 12K+ members)

- Discord: Black Forest Labs Official Server (~80K members)

Hands-On Resources:

- ComfyUI: FLUX.2-Node für Workflow-Integration

- Replicate API: FLUX.2 gehostet

- fal.ai: Schnellste Inference, Dokumentation

- Cloudflare Workers AI: FLUX.2 Integration

- RunDiffusion: FLUX.2 Suite Deployment

- Together.AI: API Access

- Hugging Face Spaces: Kostenlose Demo mit Limits

Technische Dokumentation:

- NVIDIA FP8 Optimization Guide: blogs.nvidia.com

- API Documentation für Developer Access: BFL Docs

Comparative Reviews:

- The Decoder: „Black Forest Labs launches Flux 2 with multi-reference feature“

- VentureBeat: „Black Forest Labs launches Flux.2 AI image models to challenge Nano Banana Pro and Midjourney“

- MarkTechPost: „FLUX.2: A 32B Flow Matching Transformer for Production Image Pipelines“

- WinBuzzer: „Black Forest Labs Launches FLUX.2 ‚Reasoning‘ Image Model Optimized for NVIDIA RTX GPUs“

Vergleiche mit Konkurrenten:

- Google Nano Banana Pro: blog.google/technology/ai/nano-banana-pro/

- Midjourney v7 Documentation: docs.midjourney.com