Es ist Juli 2025, und die chinesische AI-Landschaft erlebt dank schnell zu begeisternder Youtube Influencer gerade ihren nächsten Orgasmus der Selbstdarstellung. Nach dem DeepSeek-Schock zu Jahresbeginn, der die Tech-Märkte wie eine kalte Dusche traf, steht nun Moonshot AIs KIMI K2 im Rampenlicht und verspricht – man höre und staune – eine Revolution in der agentischen KI-Entwicklung. Am 11. Juli 2025 veröffentlicht, soll das Open-Source-Modell endlich das halten, was Projekte wie Manus nicht einlösen konnten. Die Frage ist nur: Ist das diesmal echter Durchbruch oder wieder nur Vegas-Glitzer mit chinesischen Charakteristika?

Manchmal fühlt sich der AI-Markt tatsächlich an wie die Hauptstraße von Vegas nach Mitternacht: überall grelle Versprechen, aber am Ende gewinnt meistens das Haus. Wir suchen die Nischen, die wirklich leuchten – und KIMI K2 könnte eine davon sein. Oder auch nicht.

Die Architektur-Anatomie: Wenn 1 Billion Parameter auf Realität treffen

Visualisierung einer Mixture-of-Experts Architektur mit Token-Routing zu verschiedenen Expert-Netzwerken, basierend auf Top-k-Selektion

KIMI K2 ist kein gewöhnlicher Parameter-Gigantismus-Versuch, sondern folgt der Mixture-of-Experts (MoE) Architektur – einem Ansatz, der mittlerweile so etabliert ist wie Espresso in italienischen Bars. Die beeindruckenden 1 Billion Gesamtparameter klingen nach Marketing-Masturbation, aber hier passiert etwas Interessantes: Das Modell aktiviert pro Inferenz nur 32 Milliarden Parameter. Das ist wie ein Orchester, das nicht alle Instrumente gleichzeitig spielt, sondern je nach Stück die passende Sektion aktiviert.

Yang Zhilin, der Tsinghua-Absolvent hinter Moonshot AI, setzt dabei auf den MuonClip-Optimizer – ein Name, der klingt wie ein Teilchenbeschleuniger-Experiment, aber tatsächlich ermöglichte, ein 1-Trillion-Parameter-Modell mit 15,5 Billionen Tokens zu trainieren. Mit „null Trainingsinstabilität“, wie das Team stolz verkündet. (Anmerkung: In der AI-Welt ist „null Instabilität“ ungefähr so selten wie ehrliche Politiker – wenn es stimmt, ist es bemerkenswert.)

Die 384 Experten-Netzwerke arbeiten zusammen, wobei pro Token nur 8 Experten aktiv werden. Das übertrifft DeepSeeks 256 Experten deutlich – eine Differenzierung, die sich anfühlt wie der Unterschied zwischen einem 256-Kanal-Mischpult und einem 384-Kanal-Mischpult. Technisch relevant, aber revolutionär? Die sparse Activation ermöglicht es jedenfalls, die Recheneffizienz drastisch zu steigern, während die Wissenskapazität exponentiell wächst. Was auf dem Papier elegant aussieht, muss sich in der Praxis erst noch bewähren.

Performance-Realität: Wo die Zahlen nicht lügen (meistens)

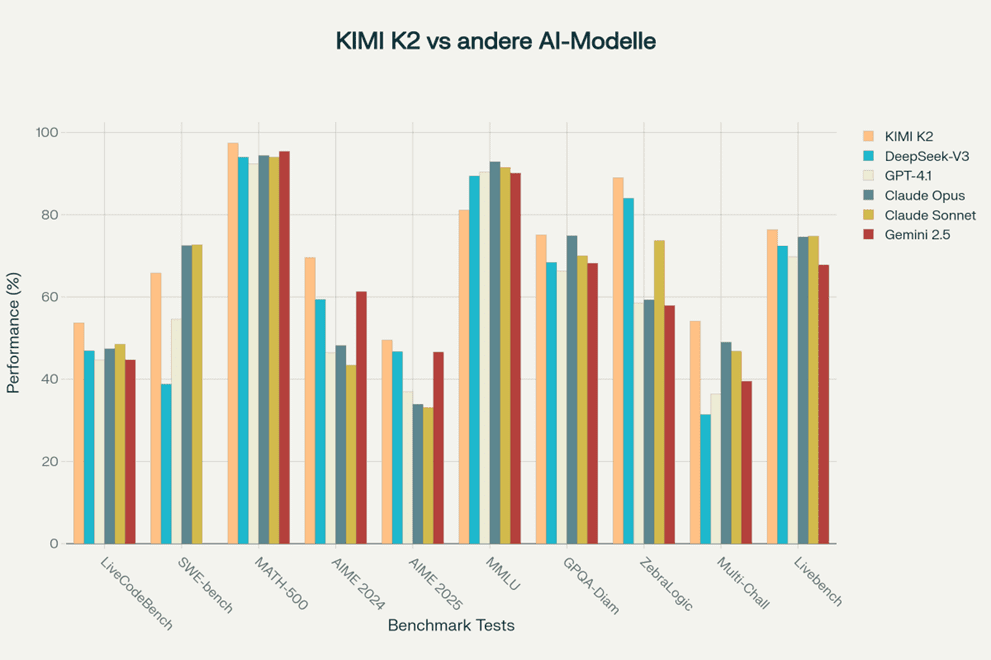

Benchmark-Performance-Vergleichsgrafik von KIMI K2 vs. führende AI-Modelle in verschiedenen Kategorien (LiveCodeBench, SWE-bench, MATH-500, MMLU)

Die Benchmark-Ergebnisse zeichnen ein differenziertes Bild, das typisch ist für die aktuelle AI-Landschaft: Brillanz in spezialisierten Bereichen, Mittelmäßigkeit in anderen. KIMI K2 zeigt besonders in coding-intensiven und mathematischen Aufgaben außergewöhnliche Stärken, während es in traditionellen Sprachverständnis-Tests eher wie ein begabter Fachidiot wirkt. Diese Spezialisierung ist kein Zufall – das Modell wurde explizit für „agentic capabilities“ optimiert, also die Fähigkeit, autonome, mehrstufige Aufgaben zu bewältigen.

Die herausragenden Leistungen sind durchaus beeindruckend: LiveCodeBench v6 mit 53,7 Prozent (vs. DeepSeek-V3: 46,9 Prozent, GPT-4.1: 44,7 Prozent), SWE-bench Verified mit 65,8 Prozent im Single-Attempt-Modus, und MATH-500 mit 97,4 Prozent Genauigkeit. Bei AIME 2024 erreicht KIMI K2 sogar 69,6 Prozent – deutlich vor GPT-4.1 mit 46,5 Prozent. Das sind keine Zahlen, die man wegdiskutieren kann.

Aber dann kommt der Reality-Check: Bei MMLU erreicht KIMI K2 nur 81,1 Prozent, während Claude Opus 4 mit 92,9 Prozent davonzieht. Das ist wie ein Pianist, der Rachmaninoff fehlerfrei spielt, aber bei „Happy Birthday“ ins Stolpern gerät. Diese Diskrepanz wirft Fragen über die Generalisierungsfähigkeit auf und zeigt, dass wir es mit einem hochspezialisierten Werkzeug zu tun haben, nicht mit einem Allround-Genie.

Benchmarks sind das Horoskop der AI-Industrie – jeder glaubt daran, aber niemand weiß genau, was sie wirklich bedeuten. KIMI K2 wurde explizit für „agentic capabilities“ optimiert, was erklärt, warum es bei Code-Generation glänzt, aber bei allgemeinem Sprachverständnis schwächelt. Es ist wie ein Formel-1-Auto auf der Autobahn – beeindruckend, aber nicht für jeden Zweck geeignet. Die Frage ist: Brauchen wir wirklich weitere Spezialist-Modelle oder sollten wir auf Generalist-Systeme setzen?

Die Kosten-Revolution: Wenn Preise zum Politikum werden

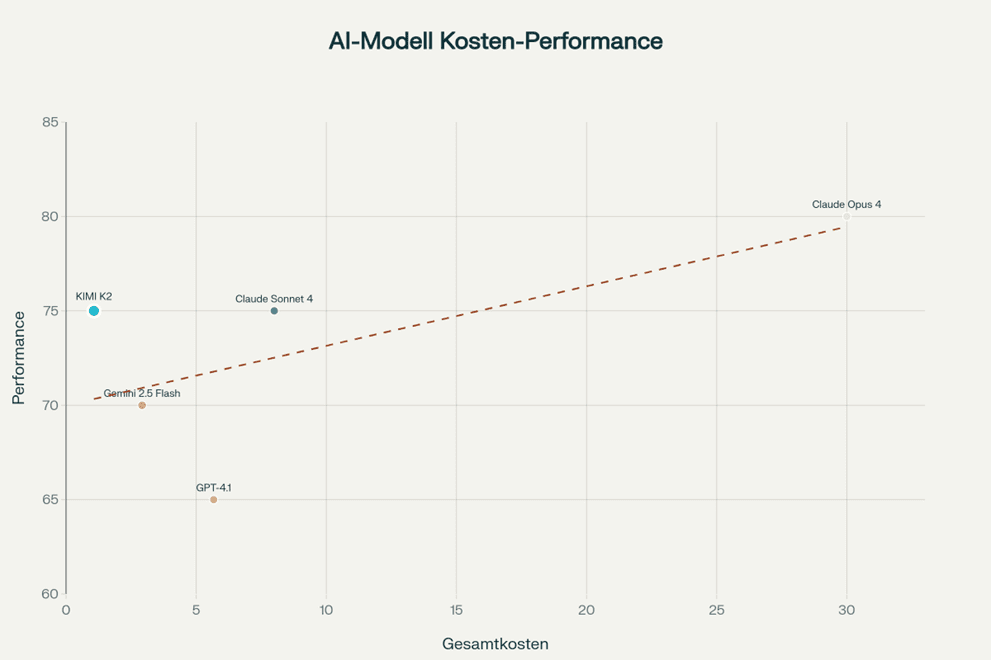

Kosten-Performance-Vergleichsgrafik verschiedener AI-Modelle pro Million Tokens

Der wahre Disruptions-Faktor liegt nicht in der Performance, sondern in der radikalen Kosteneffizienz. Mit 0,60 USD pro Million Input-Tokens und 2,50 USD pro Million Output-Tokens unterbietet KIMI K2 selbst kostengünstige Alternativen wie Gemini 2.5 Flash deutlich. Bei einer 3:1 Input-Output-Ratio kostet KIMI K2 nur 1,07 USD pro Million gemischte Tokens – verglichen mit 30,00 USD für Claude Opus 4.

Diese Preisgestaltung macht KIMI K2 95 Prozent günstiger als OpenAIs o1-Modell. Das ist keine Optimierung, das ist eine Kampfansage. Und es funktioniert: Während westliche Unternehmen noch über Kostenmodelle diskutieren, ermöglicht KIMI K2 es Entwicklern, AI-Agenten in großem Maßstab zu implementieren, ohne dass das CFO-Budget explodiert.

Die Frage ist nur: Ist das nachhaltig oder subventionierte Markteroberung? Chinas 912 Milliarden USD an staatlichen Venture-Capital-Investitionen über das vergangene Jahrzehnt lassen ahnen, dass hier nicht nur Marktmechanismen am Werk sind. ByteDances Doubao kostet 0,0001 USD pro 1K Tokens – das ist 99,8 Prozent günstiger als GPT-4. Alibabas Qwen liegt 83 Prozent unter westlichen Preisen. Bei solchen Zahlen fragt man sich, ob hier überhaupt noch Gewinnmargen existieren oder ob wir Zeugen eines staatlich orchestrierten Preiskriegs werden.

Diese aggressive Preispolitik ist Teil einer größeren Strategie: China will nicht nur technologisch aufholen, sondern den globalen AI-Markt durch Kostenvorteile dominieren. Für Entwickler ist das großartig – für die langfristige Marktgesundheit möglicherweise problematisch.

Moonshot AI: Aufstieg, Fall und Comeback-Versuch

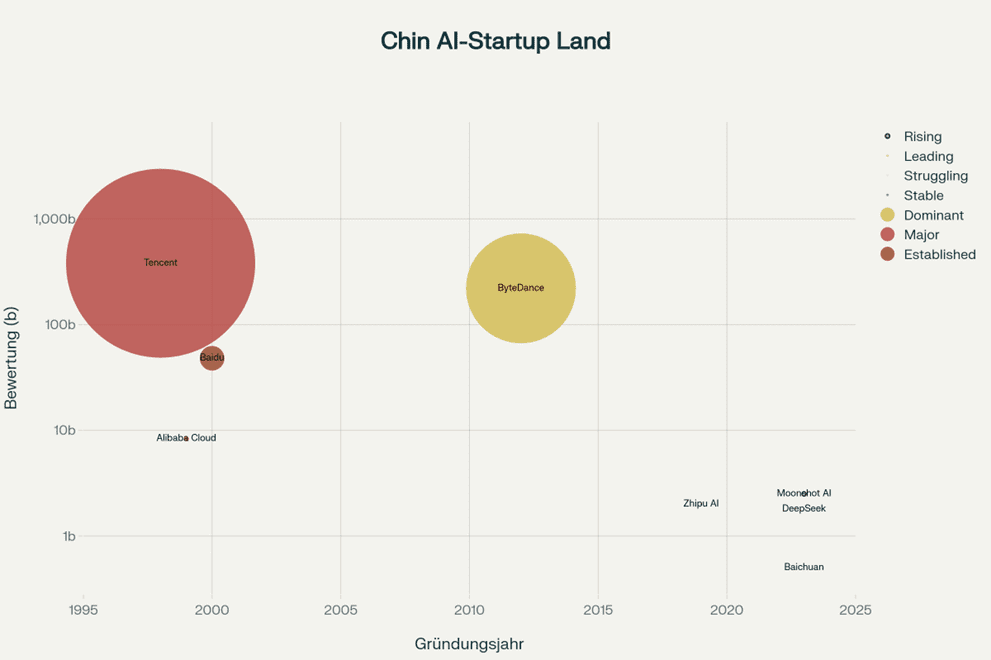

Moonshot AI befindet sich in einer komplexen Marktposition, die symptomatisch für die Volatilität der chinesischen AI-Szene ist. Mit einer Bewertung von 2,5 Milliarden USD und der Unterstützung von Alibaba gehört das Unternehmen zu Chinas „Four Tigers“ der AI-Startups. Aber der Weg war alles andere als linear.

2024 erlebte das Unternehmen einen kometenhaften Aufstieg, als die Kimi-App zur drittstärksten AI-Anwendung nach monatlich aktiven Nutzern avancierte. Dann kam der DeepSeek-Schock im Januar 2025, und plötzlich war Moonshot nur noch auf Platz 7 bis Juni 2025. KIMI K2 stellt somit einen technisch fundierten, aber auch verzweifelten Versuch dar, die verlorene Marktposition zurückzugewinnen.

Marktpositions-Grafik der chinesischen AI-Startups mit Bewertungen und Ranking-Veränderungen 2024-2025

Es ist wie bei einem Startup, das nach dem ersten Hype merkt, dass Aufmerksamkeit nicht automatisch in nachhaltiges Wachstum umschlägt. Die Open-Source-Strategie unter Apache 2.0 Lizenz ist dabei sowohl technische Entscheidung als auch Marketing-Notwendigkeit – wer nicht mehr durch Exklusivität überzeugen kann, muss durch Zugänglichkeit punkten. Diese Entscheidung zeigt auch, wie ernst die Lage für Moonshot geworden ist. Open Source bedeutet Verzicht auf Lizenzeinnahmen zugunsten von Marktanteil und Mindshare.

Die Alibaba-Unterstützung bietet finanzielle Stabilität, aber auch Abhängigkeit. In Chinas AI-Ökosystem sind staatliche und halbstaatliche Investoren allgegenwärtig, was Innovationsfreiheit und Marktdruck in einem komplexen Gleichgewicht hält.

Der Manus-Faktor: Warum AI-Agenten ein Versprechen bleiben

Die Erwähnung von Manus ist bezeichnend für die aktuellen Herausforderungen im AI-Agent-Bereich. Manus, entwickelt von Butterfly Effect und als „weltweit erster vollautonomer AI-Agent“ beworben, zeigte 2025 beeindruckende Demos: autonome Flugbuchung, Aktienanalyse, Website-Erstellung. Über 200.000 Views auf sozialen Medien, mediale Aufregung – und dann die Ernüchterung.

Trotz technischer Brillanz kämpft Manus mit fundamentalen Problemen: Weniger als 1 Prozent der Warteliste erhält Zugang, die Kosten liegen bei bis zu 199 USD monatlich, und die Performance schwankt zwischen genial und katastrophal. Das Unternehmen musste sogar nach Singapur umziehen, um US-China-Handelsbeschränkungen zu umgehen. Diese Skalierungsschwierigkeiten und die inkonsistente Performance spiegeln ein breiteres Problem wider: die Kluft zwischen kontrollierten Demonstrationen und echter Produktionsreife.

Manus‘ Situation spiegelt die breiteren Probleme der agentic AI wider: Die Kluft zwischen Demonstrations-Videos und produktionsfähiger, zuverlässiger Leistung bleibt erheblich. Es ist wie bei autonomen Autos – die Demos sind beeindruckend, aber die letzten 10 Prozent zur Marktreife erweisen sich als die schwierigsten 90 Prozent der Arbeit. KIMI K2 versucht, genau diese Lücke zu schließen, indem es sich von Anfang an auf agentic capabilities fokussiert statt auf allgemeine Sprachfähigkeiten.

Der DeepSeek-Moment: Wenn ein Startup die Welt erschüttert

Der „DeepSeek-Moment“ im Januar 2025 veränderte die globalen AI-Machtverhältnisse fundamental. DeepSeek R1, angeblich trainiert für nur 5,6 Millionen USD (vs. 100 Millionen USD für GPT-4), erreichte GPT-o1-Level-Performance bei einem Zehntel der Rechenleistung. Das war kein inkrementeller Fortschritt, das war eine tektonische Verschiebung.

Die Marktreaktion war brutal: NVIDIA verlor 17 Prozent Kurswert und 600 Milliarden USD Marktwert wurden vernichtet. OpenAI und Google reagierten innerhalb von Tagen mit Preissenkungen. Plötzlich war klar, dass chinesische Firmen durch algorithmische Innovationen und sparsame Architekturen mit westlichen Giganten konkurrieren können – und das trotz US-Exportbeschränkungen für fortgeschrittene AI-Chips.

DeepSeek demonstrierte, dass in der AI-Entwicklung nicht nur Brute-Force-Skalierung zählt, sondern auch algorithmische Eleganz. Es war wie David gegen Goliath, nur dass David diesmal eine Schleuder aus mathematischen Optimierungen verwendete. Der Paradigmenwechsel von „Brute-Force-Skalierung“ zu „algorithmischer Effizienz“ prägt seitdem die gesamte Industrie.

Dieser Schock erklärt auch, warum Moonshot AI mit KIMI K2 so aggressiv vorgeht. In einem Markt, in dem ein relativ unbekanntes Startup die etablierte Ordnung über Nacht umwerfen kann, ist Stillstand gleichbedeutend mit Rückschritt.

Kritische Bewertung: Innovation oder elaborate Imitation?

KIMI K2s Position im Markt muss kritisch hinterfragt werden. Die technische Analyse zeigt, dass das Modell im Wesentlichen eine „DeepSeek V3 mit mehr Experten“ darstellt. Die Architektur-Unterschiede sind inkrementell, nicht revolutionär: 384 vs. 256 Experten, reduzierte Attention Heads (64 vs. 128), weniger Dense Layers (1 vs. 3).

Die Performance-Gains sind real, aber nicht dramatisch. In vielen Benchmarks liegt KIMI K2 nur marginal über DeepSeek V3, was Fragen zur Kosten-Nutzen-Relation der zusätzlichen Komplexität aufwirft. Es ist wie ein Smartphone-Upgrade – technisch verbessert, aber nicht unbedingt ein Grund für Euphorie.

Mehrere Faktoren deuten darauf hin, dass wir uns möglicherweise in einer AI-Übertreibungsphase befinden: Der Bewertungs-Disconnect von 2,5 Milliarden USD für ein zwei Jahre altes Startup, der Fokus auf selektive Benchmarks statt umfassende Evaluation, Open-Source als Notwendigkeit statt Großzügigkeit, und die ständigen Modell-Releases ohne fundamentale Durchbrüche. Dazu kommt der rapid feature churn – ständige neue Versionen ohne Zeit für echte Marktvalidierung.

Die User Adoption bleibt trotz technischer Fortschritte niedrig, kommerzieller Erfolg ist schwer nachweisbar, und die Produktionsreife hinkt den Demos hinterher. Das alles sind klassische Bubble-Indikatoren.

Geopolitische Dimensionen: Tech-Krieg als Innovationstreiber

KIMI K2 muss auch im Kontext der US-China-Tech-Rivalität betrachtet werden. Die Open-Source-Strategie chinesischer Firmen ist nicht nur technisch motiviert, sondern auch geopolitisch kalkuliert: Soft Power durch globale Entwickler-Communities, Standard-Setting durch Architektur-Paradigmen, Sanktions-Umgehung durch Technologie-Transfer, und Talentakquise durch internationale Forscher.

Die Wirksamkeit dieser Strategie zeigt sich in den US-Reaktionen: OpenAI verschob die angekündigte Open-Source-Veröffentlichung „aus Sicherheitsgründen“ – nur Stunden nach KIMI K2s Launch. Wenn das kein Zeichen für Nervosität ist, was dann?

China verfolgt dabei eine systematische Strategie: Baidu meldet „mehrere hundert Millionen Yuan“ Umsatz mit Ernie Bot bei 200 Millionen täglichen API-Aufrufen. Tencent integriert Hunyuan in über 180 Services einschließlich WeChat. Diese Zahlen zeigen, dass chinesische AI-Firmen nicht nur experimentieren, sondern bereits nennenswerte kommerzielle Erfolge verzeichnen.

Die 912 Milliarden USD an staatlichen Venture-Capital-Investitionen über das vergangene Jahrzehnt ermöglichen es chinesischen Unternehmen, Verluste hinzunehmen, um technologische Souveränität zu erreichen. Das ist Industriepolitik im 21. Jahrhundert – und sie zeigt Wirkung.

Fazit: Substanz in einem Meer von Hype

KIMI K2 ist weder das „Open Source Wunder“ noch der reine Hype, als den es verschiedene Seiten darstellen möchten. Die Realität ist nuancierter und interessanter: Es ist ein technisch kompetentes, kosteneffizientes Werkzeug für Entwickler, die agentic AI-Anwendungen aufbauen möchten. Die genuinen Innovationen – drastische Kostenreduktion, agentic Spezialisierung, stabile Trainings-Pipeline für Trillion-Parameter-Modelle, echte Verfügbarkeit unter Apache 2.0 Lizenz – sind real und relevant.

Aber es ist auch ein reaktiver Produktlaunch eines Unternehmens, das seine Marktposition verteidigen muss. Die inkrementellen Verbesserungen, Spezialisierungs-Trade-offs und ungeklärten Sustainability-Fragen zeigen, dass wir es nicht mit einer revolutionären Disruption zu tun haben, sondern mit einem soliden Schritt in der kontinuierlichen Evolution der AI-Landschaft.

Die wahre Bewährungsprobe wird in den kommenden Monaten erfolgen: Kann KIMI K2 nachhaltige Adoption generieren und Moonshot AI zurück in die erste Liga katapultieren? Die technischen Grundlagen sind gelegt, die Preise sind aggressiv, die Open-Source-Strategie ist klug. Ob daraus ein langfristiger Erfolg wird, hängt von Faktoren ab, die weit über reine Performance-Benchmarks hinausgehen – Entwickler-Erfahrung, Enterprise-Tauglichkeit, Ökosystem-Integration und letztendlich die Fähigkeit, echte Probleme zu lösen statt nur Benchmarks zu optimieren.

Manchmal ist der beste Ansatz tatsächlich, nicht auf jeden Hype-Zug aufzuspringen, sondern wie ein Flaneur durch die AI-Landschaft zu wandeln und zu schauen, was wirklich bleibt, wenn der Rauch verzogen ist. KIMI K2 könnte durchaus dazugehören – oder auch nicht. Für alles andere gibt’s immer noch Notion und eine Tasse Tee.

(Anmerkung: Wir wissen, dass unsere eigene Skepsis manchmal übertrieben wirkt. Steht auf der Liste – und zwar weiter oben als das SEO-Keyword-Massaker unserer Konkurrenz.)

Weiterführende Links & Ressourcen

- KIMI K2 Official GitHub Repository – Vollständiger Quellcode und technische Dokumentation

- Reddit Technical Discussion: KIMI K2 vs DeepSeek V3 Architecture – Community-Analyse der Architektur-Unterschiede

- CNBC: Alibaba-backed Moonshot releases KIMI K2 – Marktkontext und Unternehmenshintergrund

- Scott Logic: GenAI Sustainability Review 2025 – Umfassende Analyse der aktuellen AI-Marktdynamiken

- Britannica: DeepSeek and the AI Revolution – Historische Einordnung des DeepSeek-Moments

- Novita AI: KIMI K2 Instruct Deployment Guide – Praktische Implementierung und Kostenanalyse